Instabilités hydrodynamiques et ondes non-linéaires

|

Organisation : |

Paul Clavin (IRPHE Marseille), Christophe Josserand (Institut D’Alembert, Paris) et Yves Pomeau (ENS Paris) |

|

Coordinateur : |

Paul Clavin |

|

Dates : |

17 au 21 mai 2010 |

| Participants : |  |

Mardi 18 mai

9h-10h30 : Paul Clavin (IRPHE, Marseille) “Introduction à la combustion”

11h-12h30 : Paul Clavin (IRPHE, Marseille) “Instabilités des flammes”

16h-18h : Guy Joulin (Institut P’, Poitiers) “Géométrie du front de flamme et Acoustique Haute-Fréquence I”

18h30-19h30 : Jose Grana (IRPHE, Marseille) “Flammes fortement instationnaires”

Mercredi 19 mai

9h-10h30 : Guy Joulin (Institut P’, Poitiers) “Géométrie du front de flamme et Acoustique Haute-Fréquence II”

11h-12h30 : Javier Sanz (ETSI Madrid) “Stabilité hydrodynamique de chocs sphériques auto-semblables”

16h-18h : Yves Pomeau (ENS, Paris) “L’état de la mer”

18h-19h : Gilou Agbaglah (Institut D’Alembert, Paris) “Rétractation capillaire”

Jeudi 20 mai

9h-10h : Jérôme Hoepffner (Institut D’Alembert, Paris) “Une vague pour l’atomisation”

10h-11h : Christophe Almarcha (IRPHE, Marseille) “Fluides réactifs”

11h30-12h30 : Marco Rivetti (Institut D’Alembert, Paris) “Dynamique élasto-capillaire”

15h-18h : Table ronde

Vendredi 21 mai

9h-10h30 : Laurent Duchemin (IRPHE, Marseille) “Singularité et impacts”

11h-12h30 : Christophe Josserand (Institut D’Alembert, Paris) “Instabilité auto-semblable de bourrelets”

-

14ème Aux rencontres de Peyresq : “Equilibre et propagation dans les milieux structurés”

|

Organisation : |

Université de Nice Sophia Antipolis (LPMC) |

|

Coordinateur : |

Xavier Noblin |

|

Dates : |

31 mai au 4 juin 2010 |

| Participants : | Turchi Alessio (I), Gassa Feugaing Canisius Martia, Gerard Thomas (B), Rojas Nicolas (RCH), Brun Pierre-Thomas (F), Beauvier Edouard (F), Mauroy Valerie (F), Jiang Tetyana, Leroux Alphonse (F), Mills Pierre (F), Argentina Médéric (F), Georgelin Marc (F), Vandenberghe Nicolas (F), Ligoure Christian (F), De Wit Anne (B), Audoly Basile (F), Enoch Stefan (F), Castaing Bernard (F), Pocheau Alain (F), Noblin Xavier (F), Pomeau Yves (F). |

La cartographie et son épistémologie

|

Organisation : |

Eric Guichard |

|

Coordinateur : |

Jean Dhombres |

|

Dates : |

14 au 16 juin 2010 |

|

Participants : |

Pierre Borgnat (CNRS et ENS-Lyon), Jean Dhombres (CNRS et EHESS), Nicole Dhombres, Patrick Flandrin (CNRS et ENS-Lyon), Éric Guichard (ENSSIB et ENS), Olivier Joseph, Claude Kergomard (ENS et CERES), Thierry Lafouge (Univ. Lyon-I), Geneviève Lallich-Boidin (Univ. Lyon-I), Isabelle Lefort (Univ. Lyon-II), Raphaële Mouren (ENSSIB), Gilles Palsky (Univ. Paris-I), Philippe Pelletier (Univ. Lyon-II), Patricia Radelet de Grave (Univ. catholique de Louvain), Daniel Regnier-Roux (CNRS et ENS-Lyon), Pascal Robert (Univ. Montpellier 3), Philippe Rygiel (Univ. Paris-I et ENS) |

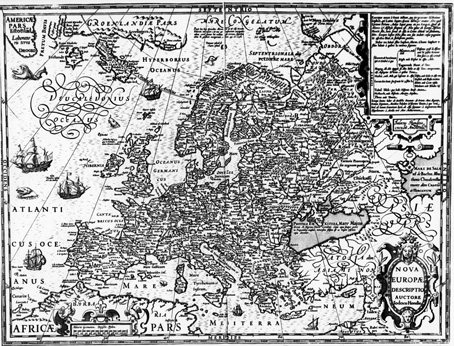

Le projet de ces journées était de réunir des personnes spécialistes de la cartographie ou intéressées par la preuve graphique et les interactions entre écriture et raisonnement scientifique. Ce fut l'occasion d'explorer, dans une perspective épistémologique, les pratiques lettrées en relation avec la cartographie et l'écriture des représentations du monde.

Malgré des pluies torrentielles, les participants ont pu échanger longuement sur ce thème réactualisé par l'informatique et l'internet. En effet, la dizaine de conférences ont été suivies de débats, et de nombreuses discussions, en journée comme en soirée, ont permis aux conférenciers comme aux invités de partager leurs expériences et analyses. Ce qui fut d'autant plus fructueux que les profils disciplinaires des participants étaient fort variés, couvrant l'histoire, la géographie, les sciences de l'information et de la communication, la physique et les mathématiques.

Tel était le but du colloque : permettre un échange qui aborde la dimension épistémologique de la cartographie, y compris quand elle se dissumule en des pratiques passées ou actuelles.

Par exemple quand elle permet de nouvelles représentations du monde chez les Chinois par le biais de mesures de longitudes dérivées de l'observation des satellites de Jupiter (Jean Dhombres) ou quand elle transforme radicalement la façon de fouler le monde (et ses océans) avec l'invention par Mercator de la représentation conforme (Patricia Radelet de Grave). En effet, la part des mathématiques est souvent négligée quand est évoquée la cartographie, tout comme le détail des apports épistémologiques de la première discipline.

Le succès de ces journées fut aussi garanti par la grande culture scientifique des participants: historiens-statisticiens, géographes informaticiens, etc. et aussi physiciens évoquant comment ils réalisent des cartes, comment ils inventent la sémiologie graphique la plus adaptée à leurs raisonnements (Pierre Borgnat). Approche qui rappelle celle des ingénieurs du XIXe siècle et qui montre les limites des tentatives de théorisation de la sémiologie par Jacques Bertin (Gilles Palsky), et qui ouvre des perspectives dialogiques avec les nouvelles disciplines comme les sciences de l'information et de la communication qui s'interrogent sur la façon dont la carte signale l'importance de l'outillage mental et la réflexivité de l'écriture (Pascal Robert).

Comme il le fut rappelé lors de la discussion qui a suivi la présentation des apports épistémologiques de la cartographie contemporaine (Éric Guichard), l'épistémologie de la cartographie est un chantier fructueux, à condition qu'elle reste concrète, voire disciplinaire. C'est aussi pourquoi le colloque avait fait la part belle aux historiens qui décrivaient de façon détaillée des usages passés de la cartographie (Olivier Joseph), aux géographes, qui restent les premiers épistémologues en acte de la carte (Philippe Pelletier), surtout quand ils sont confrontés à un nouvel outillage, massif et en réseau, par exemple quand ils s'attellent à l'étude du climat (Claude Kergomard). Ici, l'épistémologie se fabrique et se renouvelle sous nos yeux.

En conclusion, ce colloque passionnant a donné envie aux participants de prolonger leurs efforts en collectif sur ce thème de l'épistémologie et de la cartographie, et ses actes feront prochainement l'objet d'un numéro spécial de revue savante.

Carte de l’Europe - Nova Europea -, in Atlas de Mercator, 1613.?Photo : Anvers, Musée Plantin-Moretus.

Lundi 14 juin

• Introduction. Éric Guichard

• Les mathématiques de la carte : une réflexion à partir du XVIIe siècle. Jean Dhombres

• La carte du monde publiée par Mercator en 1569. Patricia Radelet de Grave

• Repas

• Silences de la carte, savoirs et savoir-faire des montagnards au XVIIIe siècle : Pierre de Bourcet et la cartographie militaire des Alpes. Olivier Joseph

• Orient, Occident et méridien origine. Philippe Pelletier

• Discussion: L'histoire des cartographes, ses apports épistémologiques et les perceptions épistémologiques des cartographes du passé.

• Repas du soir

• Présentation-projection de quelques cartes et atlas anciens. Éric Guichard

Mardi 15 juin

• Cartographier un objet variable dans le temps et dans l'espace : le climat. Claude Kergomard

• Analyse et visualisation de la dynamique des Vélo'v. Pierre Borgnat

• Repas

• Mythologies et mythes de la sémiologie graphique. Gilles Palsky

• Que peut apporter une théorie générale des technologies intellectuelles à l'approche de la carte? Pascal Robert

• Discussion : L'informatique, les cartes de et sur l'internet, et l'éventuel renouvellement épistémologique qu'elles induisent

• Repas du soir

• Discussion : La preuve graphique, en cartographie et en physique.

Mercredi 16 juin

• Cartographie informatique et réflexivité. Éric Guichard

• Discussion : Apports heuristiques et épistémologiques de la cartographie contemporaine aux sciences sociales (et réciproquement).

• Conclusion et suites à donner au colloque.

• Repas

Peyresq Physics 15

| Organisation : | Université Libre de Bruxelles |

| Coordinateur : | Edgar Gunzig |

| Dates : | 19 au 25 juin 2010 |

Compte rendu :

Les physiciens sont de plus en plus convaincus que le concept de trou noir représente un laboratoire théorique essentiel qui pourrait fournir la clef des plus grandes énigmes de la physique d’aujourd’hui. Nul doute que l’existence de l’hypothétique gravité quantique, par exemple, devrait se manifester au travers des propriétés étonnantes des trous noirs. C’est pourquoi, une partie importante des activités de Peyresq Physics 15 s’est articulée autour de diverses facettes de ces propriétés. Nous donnons ci-dessous quelques exemples d’exposés-discussions dédiés à cette problématique. Remarquons que les interlocuteurs qui prennent une part active au débat sont non seulement des physiciens célèbres de tout premier plan (Steve Carlip, Bill Unruh, Valeri Frolov, Rafael Sorkin…) mais également des physiciens plus jeunes voire des doctorants (Sergey Sibiryakov, Albert Roura…).

Quelques autres thématiques ont été abordées et certaines d’entre-elles seront au programme de Peyresq Physics 16 en juin 2011. Il y a entre-autres l’approche dite des “causal sets” qui représente une voie intéressante, prometteuse et audacieuse vers la gravité quantique. Quels sont ses liens avec les trous noirs, voilà un des exemples des futurs débats qui seront menés à Peyresq.

Dans ce rapport, nous évitons tout recours à des formulations mathématiques et essayons de rester aussi “simplement” descriptifs que possible. Nous attendons avec impatience de voir ce que seront les éventuels nouveaux aspects de la “réalité” que les débats de Peyresq 16 pourront nous révéler.

• Steve Carlip, Director of the Department of Physics, University of California, Davis, USA.

It's been 80 years since the first attempt was made to combine general relativity and quantum mechanics into a quantum theory of gravity. In that time, we have learned a lot about what doesn't work, but the ultimate goal still seems distant.

One of the very few things we really know about quantum gravity has to do with quantum black holes. As Bekenstein and Hawking showed, black holes are “hot” -- like a hot poker, a black hole glows, radiating light in a characteristic pattern that depends on its mass and charge. Such thermal properties normally reflect the underlying microscopic constituents (or, in physicists’ parlance, he microscopic degrees of freedom) of a system. When we say, “The air is hot”, for instance, we really mean, “The molecules of air are moving rapidly”. For a black hole, though, there are no classical (nonquantum) degrees of freedom available -- no classical “molecules”. So the Hawking temperature and Bekenstein-Hawking entropy are almost certainly telling us about the quantum gravitational degrees of freedom.

A basic mystery is the “universality” of these degrees of freedom -- the fact that many different and, in fact, inconsistent approaches to quantum gravity give the same answers for black hole thermodynamics. One possible answer is that the relevant theory is completely controlled by the symmetries of the event horizon, in particular by a symmetry called conformal invariance. Interest in this possibility was revived recently with the discovery of an “extremal Kerr/CFT correspondence”, a description of the degrees of freedom of a rotating black hole in terms of such a horizon symmetry.

As it was originally formulated, though, this description only worked for extremal black holes, that is, black holes spinning at the fastest possible rate. The talk described two possible extension of this result to arbitrary black holes, spinning at any speed.

• Rafael Sorkin, Perimeter Institute, Canada.

Among the various ideas put forward in the search for a theory of quantum gravity, the causal set hypothesis is distinguished by its logical simplicity and by the fact that it incorporates the assumption of an underlying spacetime discreteness organically and from the very beginning.

In the way that it has developed, the causal set hypothesis has given rise to a mathematical framework (the “dynamics of sequential growth”) in which time is an active process of “becoming” that can be identified with the continual birth of new elements of the causal set. As he described at an earlier Peyresq conference, this picture in turn has led to new types of cosmological scenario that hold the potential to account for the puzzling fact that our cosmos is very nearly spatially flat and homogeneous.

At this summer’s Peyresq conference he summarized some recent progress in the causal set program :

(1) the setting up of a quantum field theory for a scalar field on a background causal set;

(2) the identification of a causal set invariant corresponding to the scalar-curvature action of continuum gravity (and which admits of an analytic continuation serving the same purpose as Wick rotation).

The former prepares the way for such things as studying black hole radiance with a Lorentz-invariant cutoff, the latter for Monte Carlo simulations of a causal set dynamics, and in particular of cosmology a la causet.

• Valeri Frolov, co-director of the Physics Department, University of Alberta, Canada.

His first talk was devoted to hidden symmetries and black holes. Symmetry is one of the most important concept of the science. In physics and mathematics the symmetry allows one to simplify a problem, and often to make it solvable. According to the Noether theorem symmetries are responsible for conservation laws. Besides evident (explicit) spacetime symmetries, responsible for conservation energy, momentum, and angular momentum of a system, there may also exist what is called hidden symmetries, which are connected with more involved integrals of motion. A remarkable fact is that black holes in four and higher dimensions always possess a set (“tower”) of hidden symmetries which make the equations of motion of particles and light completely integrable. The talk gave a general review of the recently obtained results. The main focus was on understanding why at all black holes have something (symmetry) to hide.

The second talk was devoted to charged particle motion in magnetized black holes. It was demonstrated, that the magnetic field existing in the vicinity of a black hole may affect dramatically of observable effects.

• Bill Unruh, Director of the Department of Physics and Astronomy, University of British Columbia, Canada.

The vacuum state is a state of zero temperature, and you would expect that anything that was in contact with it, would also cool down to zero temperature. However, if the coupling of the object with the vacuuum is strong, the system looks and behaves in many ways as if it has a non-zero temperature. However this non-zero temperature also acts stangely. If you now very weakly couple a thermometer to the system, and wait, that thermometer will read that the it has a zero temperature. Thus the notion of temperature can depend on exactly how it is determined. If you measure it quickly it can be non-zero while if you measure it slowly it can be zero. This is also related to the concept of “false decoherence” I worked on in the past, where a system looks like it has lost coherence (as in this case-- a non-zero tempertature means you have a state which has lost a lot of its cohernence) but if you look at things slowly, suddenly all that apparently lost coherence is really all still there.

• Renaud Parentani, chercheur au centre d’Orsay, Paris.

Quite surprizingly, black holes solutions which difffer from Scwarzschild are subject to several types of instabilities, some of which are poorly understood. In order to meke some progress, I focus on one particular type of instability, that called the “black hole laser effect” and discovered by Corley & Jacobson.

This instability can be described in terms of a complete set of eigen-modes that are spatially bounded. The spectrum contains a discrete and finite set of complex frequency modes which appear in pairs and which encode the laser effect. In addition, it contains usual real frequency modes which form a continuous or discrete set depending on whether the space is infinite or finite. These modes are only elastically scattered, i.e., not subject to any Bogoliubov transformation. The quantization is straightforward, but the determination of the continous spectral properties of the asymptotic fluxes is rather involved. When the supersonic region bewteen the black and white horizon schrinks, there is a minimal distance (or a minimal velocity excess) under which no complex frequency mode exists. In this case, no radiation is emitted. We link this laser effects to other instabilities which have been found for rotating black holes and charged fields propagating in electric fields. Application to Acoustic black holes in atomic Bose-Einstein condensates are also considered, and realistic simulations are performed.

• Albert Roura, Assistant Professor, Physics and Astronomy Department, University of Maryland, USA.

General relativity predicts the existence of black holes, which are finite-size regions from which nothing (not even light) can escape. However, when quantum effects are taken into account, Stephen Hawking showed more than three decades ago that they emit thermal radiation, similar to that radiated by a hot body at a given temperature. Hawking originally considered isolated black holes whose gravitational field becomes arbitrarily weak at sufficiently large distances, where the spacetime curvature is very small. In this case the temperature of the thermal radiation emitted is inversely proportional to the size of the black hole, which shrinks as it radiates energy. This process, known as black hole evaporation, happens very slowly at first and much faster during the late stages, when it has already lost most of its initial mass and it is emitting at a much higher temperature.

One can try to have an equilibrium configuration for the black hole by considering it immersed in a thermal bath of radiation at the right temperature. In contrast with a regular hot object, however, such an equilibrium would be unstable for the kind of black hole considered above: any small perturbation would lead to either the evaporation of the black hole or its indefinite growth by absorption of radiation. On the other hand, the situation can be different when a negative cosmological constant is present. In that case even arbitrarily far from the black hole there is a non-vanishing gravitational field and the spacetime is warped with a geometry asymptotically close to anti-de Sitter space, which has a finite and constant curvature radius. It has been argued that whereas the equilibrium configuration for black holes smaller than the anti-de Sitter curvature radius is also unstable, larger black holes can be in stable thermal equilibrium.

Previous studies about black holes in anti-de Sitter employ a mathematical construction involving imaginary time which suggests a natural statistical mechanical interpretation. Instead we base our analysis on the equations describing the back-reaction of the Hawking radiation on the dynamics of the spacetime geometry. This is done by including the stress tensor of the quantum fields which are being radiated as a source of Einstein's equations. A clear advantage of our approach is that one can then follow the actual evolution in real time of the perturbations around the equilibrium configurations. One can also obtain fairly easily the relaxation timescale for those perturbations in the stable case.

For more than a decade the AdS/CFT correspondence has provided a close link between conformal field theories with a large number of fields and gravity (formulated in terms of string theory) in asymptotically anti-de Sitter spacetimes with one additional dimension. By taking the strong coupling limit of the conformal field theory and the leading contribution in the number of fields, one can neglect the corrections from the finite size of the strings propagating on the background spacetime and from loops of strings, respectively. In fact, by doing so in most existing analysis only classical configurations had to be considered in the gravitational description. On the other hand, the effects that we have studied involve certain kinds of quantum loop corrections. Although small, they constitute the dominant contribution because the phenomenon is forbidden in terms of classical processes (the black hole cannot emit spherically symmetric classical gravitational waves). Our results and techniques might provide some useful hints in future attempts to examine the effects of loop corrections in AdS/CFT and the corresponding corrections due to the finite number of fields on the conformal field theory side (at strong coupling).

• Sergey Sibiryakov, postdoctorant à l’université de Lausanne

He considered solutions describing black holes in a gravitational model with?violation of Lorentz invariance. This model is motivated by the approach to?quantum gravity proposed recently in the works by P. Horava. At the same?time the model has a lot in common with the so called Einstein - aether theory?proposed before to analyze possible effects of Lorentz breaking in gravity.??

The talk was mainly concentrated on the causal structure of the black hole solutions.?This is a non-trivial question because, as a consequence of broken Lorentz symmetry, the model contains excitations propagating with arbitrarily high velocities. So one?could think that using these excitations one can probe as far as the central black?hole singularity, which would be in striking contrast to the situation in the standard?theory of gravity where the singularity is hidden beyond causal horizon. However, as was shown in the talk, this is not the case. In spite of arbitrary fast interactions, a?black hole solution still possesses a causal horizon, though different from the one?of the standard theory. In other words, the central singularity is still causally?disconnected from the region at spatial infinity. Besides, he discussed propagation of test particles in the black hole backgrounds?and addressed some issues concerning stability of the black holes.

• Larry Ford, physics department at University of Maryland.

Quantum Stress Tensor Fluctuations: Probability Distribution and Cosmological Applications.

This talk first discusses the probability distribution for quantum fluctuations of the vacuum energy density of a quantum field. The basic result is that this distribution is highly skewed. Most measurements of the energy density will yield a negative value. However, when the value is positive, its magnitude can be much larger, as there is a lower bound on the magnitude of a negative fluctuation. The second part of this talk deals with applications to inflationary cosmology. Fluctuations of the vacuum energy density during inflation can lead to density perturbations after inflation. This effect is in addition to the dominant effect due to quantum fluctuations of an inflaton field. The energy density fluctuations can lead to a non-scale invariant and non-Gaussian component which is potentially observable in the cosmic microwave background radiation.

Professeur Edgar Gunzig

5ème Ecole d’été de Traitement du Signal et des Images : Apprentissage

|

Organisateurs : |

GRETSI et GdR CNRS ISIS, avec le soutien des Ecoles Doctorales SFA et STIC (Nice), de Télécom-ParisTech et de l’INRIA |

|

Coordinateurs : |

Cédric Févotte (CNRS-Télécom-ParisTech), Patrick Flandrin (CNRS-ENS Lyon) et Laure Blanc-Féraud (CNRS-I3S Sophia) |

|

Dates : |

26 juin au 2 juillet 2010 |

| Internet : | http://peyresq10.u-bourgogne.fr/ |

|

Participants : |

Sandrine Anthoine, Xavier Artusi, Francis Bach, Cécile Bazot, Louise Benoit, Laure Blanc-Féraud, Emilie Bosc, Stéphane Canu, Olivier Cappé, Eric Debreuve, Onur Dkmen, Karim Drifi, Yohan Dupuis, Mohammed El Korso, Cédric Févotte, André Ferrari, Inbar Fijalkow, Wassim Filali, Rémi Flamary, Patrick Flandrin, Anne-Laure Fouque, Maud Franchet, Philippe Gaussier, Antoine Grigis, Houssam Halmaoui, Cédric Herzet, Nisrine Jrad, Maya Kallas, Augustin Lefèvre, Edith Le Floch, Vincent Morard, Manuel Moussallam, Xavier Navarro, Emilie Niaf, Zineb Noumir, Farid Oudyi, Maud Pasquier, Alain Rakotomamonjy, Tabea Rabafka, Cédric Richard, Matthieu Sanquer, Camille Simon, Mariano Tepper, Arnau Tibau Puig, Aurélie Voisin, Daniel Wesierski. |

Objectifs :

Le thème retenu pour 2010 était celui de l'apprentissage statistique. Ce domaine des statistiques inférentielles vise à produire des algorithmes à même d'extraire automatiquement des informations de données empiriques. Cette thématique est particulièrement centrale en traitement du signal et des images où des capteurs, potentiellement hétérogènes et en grand nombre, délivrent d’importantes masses de données généralement bruitées. D’un point de vue méthodologique, l’apprentissage statistique a trait au traitement statistique d’informations multidimensionnelles dans le cadre de problèmes de détection, estimation, optimisation, etc. Ce domaine couvre notamment les techniques de modélisation bayésienne, les modèles markoviens, les machines à vecteurs support et autres méthodes à noyau reproduisant. Du point de vue des applications, l’apprentissage statistique embrasse un large éventail de sujets, de la séparation de sources à la reconnaissance des formes, en passant par la fouille de données ou encore le filtrage.

L’objectif de cette 5ème session de l’École d’Eté de Peyresq en Traitement du Signal et des Images était donc triple :

1. Elle se proposait de développer la sensibilisation de la communauté du traitement des signaux et des images à la thématique de l’apprentissage statistique,

2. de lui faire profiter des outils les plus récents (méthodes, modèles, algorithmes) et de l’apport du cadre méthodologique lui-même.

3. Par ailleurs, l’école se donnait pour ambition d’attirer un public pluridisciplinaire intéressé à se former à des avancées méthodologiques récentes en signal et en image.

Compte rendu / Réalisation :

L’École a été organisée autour de 6 cours dispensés par des spécialistes du domaine, laissant du temps chaque jour pour des exposés des auditeurs ainsi que pour des discussions informelles.

1. Méthodes à noyaux, machines à vecteurs supports, applications en segmentation du signal (5h)

2. Méthodes parcimonieuses pour l'apprentissage statistique : théorie et algorithmes (5h)

3. Méthodes bayésiennes pour les modèles à variables latentes (5h)

4. Apprentissage statistique appliqué aux interfaces cerveau-machine (2h)

5. Méthodes d'apprentissage distribué. Application aux réseaux de capteurs (2h)

6. Sciences cognitives et robotique : le défi de l’apprentissage autonome (2h)

La session 2010 (qui faisait le plein en termes de participants) a été très riche scientifiquement et très animée. Comme les années précédentes, la qualité du lieu et de l’accueil a contribué à faire de cette semaine une rencontre à la fois studieuse et décontractée. Elle a permis de nouer de nombreux contacts entre participants (auditeurs et orateurs confondus), qui seront sans nul doute à la source de collaborations futures.

- Cédric Févotte, Patrick Flandrin et Laure Blanc-Féraud

5th ALTER-Net Summer School : "Biodiversity and Ecosystem Services"

- ALTER-Net is a network of 24 partner institutes from 17 European countries. ALTER-Net integrates research capacities across Europe: assessing changes in biodiversity, analyzing the effect of those changes on ecosystem services and informing the public and policy makers about this at a European scale. Originally funded under the 6th Framework Programme of the European Community, ALTER-Net is now operating independently.

Conveners :

Allan Watt, Centre for Ecology & Hydrology (CEH) Edinburgh, Scotland, United Kingdom; Wolfgang Cramer, Potsdam Institute for Climate Impact Research, Potsdam, Germany; Uta Fritsch, Coordinator of EURAC-Junior, Science Communication, EURAC research, Bolzano, Italy; Sabine Lütkemeier, Potsdam Institute for Climate Impact Research, Potsdam, Germany;

Coordination :

Sabine Lütkemeier, Summer School Director, PIK, Potsdam, Germany

Dates :

5 – 14 September 2010

Internet : http://www.pik-potsdam.de/alter-net/ Participants :

Victor Ávila Akerberg (Mexico), Benjamin Bodirsky (DE), Ines Geovana Carreño Rocabado (NL), Roberto Cazzolla Gatti (IT), Joanna Cent (PL), Benjamin Christen (DK), Gisella Susana Cruz Garcia (NL), Rik De Vreese (BE), Marianela Fader (DE), Kirstin Fangel (NO), Johannes Förster (DE), Ingeborg Palm Helland (NO), Sophie Herbert (BE), Katja Heubach (DE), Ágnes Kalóczkai (HU), Aidan Keith (GB), Leena Kopperoinen (FI), Torsten Krause (SE), Lasse Loft (DE), Eli?ka Lorencová (CZ), Ola Lundin (SE), Katalin Petz (NL), Liina Saar (EE), Lara Salido Grana (GB), Cláudia Santos (PT), Jennifer Schulz (DE), Ilse Simoens (BE), Nina Smits (NL), Dirk Snyman (South Africa), Nike Sommerwerk (DE), Jitka Strakova (CZ), Alexander van Oudenhoven (NL)

Lecturers : Leon Braat (NL), Wolfgang Cramer (DE), Roy Haines-Young (GB), Rik Leemans (NL), Hal Mooney (US), Marion Potschin (GB), Steve Redpath (GB), Dagmar Schröter (AT), Martin Sharman (BE), Simron Jit Singh (AT), Will Steffen (Australia), Mark Sutton (GB), Klement Tockner (DE), Jean Vancompernolle (BE), Sybille van den Hove (ES), Jiska van Dijk (NO), Allan Watt (GB) Tutors/Lecturers: Eric Arets (NL), Nicolas Dendoncker (BE), Uta Fritsch (chair of the tutors, IT), Martin Wildenberg (AT), Brooke Wilkerson (NO)

-

- OBJECTIFS :

- The summer school strived towards an integration of natural and social science aspects into the question of biodiversity and ecosystem services. The aim was, besides the aspect of environmental awareness, the dissemination, and critical review of the approach of integrated assessment of the vulnerability of ecosystems and their services and biodiversity under global change. The summer school presented the state-of-the-art of scenario techniques, stakeholder dialogues, assessments of the expected impacts on ecosystem services, ecosystem modelling approaches for selected ecosystem services and strategies for adaptation strategies. Carefully selected lectures and an interactive set-up for working groups fostered an intensive dialogue between the participants and the lecturers. Target groups were graduate students and young scientists from environmental sciences and related disciplines as well as social sciences mainly from ALTER-Net partner institutes.

The structure of the summer school included two morning lectures, daily tutored teamwork by the participants, followed by an “aperitif talk” in the late afternoon. After each presentation, time for discussion was available which nurtured good contacts between the students, tutors and speakers. A half-day hike to visit a shepherd nearby allowed the students to question a local stakeholder and also to get an impression of the local landscape. A full-day excursion exemplified land-use change on the Plateau de Valensole where wheat has been partly replaced by lavender and recently by oak trees for growing truffles. Lunch was taken at the Lac de Ste. Croix which is a reservoir dammed in the 1960s. A visit to an organic farmer and a short walk into the Gorges du Verdon completed this long and exciting day.

The 32 participants formed four working groups which each worked on a case study on the nearby region of the Var department on different sectors; i.e. agriculture, nature conservation, tourism and renewable energy. One delegate from each group and four permanent members formed a synthesis group who summarised the results of the four case studies for policy-makers. The report was written as if it had been a project funded by the EU with the acronym “PERIL” (Reducing Regional Vulnerability in the Southern Alps - Evaluation Trends and Developing Sustainable Adaptation Strategies and Managing Biodiversity). One of the major goals of the summer school, the interaction between students and lecturers, was facilitated not only by discussions during and after the lectures but also by the excursion and the intensive tutorial and team work of the students which were attended by many lecturers in the afternoons and, not-to-forget, by informal discussions during joint meals and leisure time.

Jean's introduction to PeyresqJean guiding us on our walk to the shepherdWorking on the terrace of da Vinci(Photos by Ágnes Kalóczkai, Sabine Lütkemeier,

Jean's introduction to PeyresqJean guiding us on our walk to the shepherdWorking on the terrace of da Vinci(Photos by Ágnes Kalóczkai, Sabine Lütkemeier,

Martin Sharman and Allan Watt)

-

Projet COMORE

Organisation :

Stéphanie Sorres - Centre de recherche INRIA-Sophia Méditerranée

Coordinateur :

Jean-Luc Gouze

Dates :

11 au 13 octobre 2010

Participants : Stéphanie Sorres (F), Jean-Luc Gouze (F), Olivier Bernard (F), Frédéric Grognard (B), Madalena Chaves (P), Pierre Bernhard (F), Jonathan Rault (F), Mikael Teixeira (F), Olivier Calabro (F), Andrei Akhmetzhanov (RUS), Eric Pruvost (F), Nina Moelants (B), Xiao Dong Li (VRC), Philipp Hartmann (D), Eric Benoit (F), Antoine Sciandra (F), Sophie Rabouille (F), Sakina Ayata (F), Ludovic Mailleret (F), Valérie Lemesle (F), Pierre Collet (F). Le projet COMORE est un projet commun INRIA (Unité de Recherche de Sophia-Antipolis) et CNRS, LOV, Laboratoire d’Océanographie de Villefranche sur mer, UMR 7093, CNRS/UPMC. C’est un projet de recherche en mathématiques appliquées à la biologie: http://www-sop.inria.fr/comore/main_fr.html

Les membres du projet sont tri-localisés (Sophia, Villefranche, Narbonne) et se retrouvent une fois par an pour des séminaires communs sous forme de cours et d'exposés.

L’objectif global de Comore est d’appliquer et de développer des méthodes de l’automatique (modélisation, identification, estimation, régulation, contrôle optimal, théorie des jeux) et de la théorie des systèmes dynamiques aux ressources vivantes exploitées (ressources renouvelables), afin d’en améliorer la gestion.

Axes de recherche :

• Dynamique et contrôle des pêches et de l’aquaculture.

• Modélisation et contrôle des bioréacteurs.

• Modélisation et surveillance de la croissance du phytoplancton.

• Modélisation, suivi et contrôle des procédés de traitement de l'eau.

• Modélisation de la dynamique de la forêt.

• Mathématiques de la modélisation en biologie.

• Logiciels à usage des modélisateurs et des biologistes

Compte rendu :

Antoine Sciandra : ”Carencer des microalgues en nitrate pour accroitre leur production de lipides: une affaire pas si simple que ça”

Ce travail présente différents cas d’acclimatation d’une espèce de phytoplancton (Isochrysis sp.) à des modifications de son environnement physico-chimique, avec une attention particulière portée sur la composante lipidique de la réponse aux changements. Dans ce contexte nous avons étudié les lipides à la fois comme produits (triacylglycerol) et acteurs (glycolipides) de la photosynthèse.

Nous avons étudié en particulier l’influence de plusieurs types de limitation par l’azote sur la teneur en lipides neutres des algues. Nous avons montré que la relation entre la disponibilité de l’azote et la teneur en lipide n’était pas monotone et qu'elle présentait un caractère hystérétique. Les cellules d’Isochrysis sp. n’accumulent des lipides neutres que transitoirement lors du passage d’une croissance forte vers une croissance faible.

Grace à ces différentes expériences nous avons pu mettre en évidence les relations qui existaient entre l’environnement, la croissance, et l’accumulation de réserves énergétiques comme les sucres er les lipides. La compréhension de ces mécanismes a permis de déterminer les conditions de croissance qui favorisent la production d’huile en vue d’une utilisation biocarburant. Les données ont également permis de concevoir et valider un modèle mathématique.

Sakina Ayata : “Modélisation de la dispersion larvaire et de la connectivité des métapopulations d’invertébrés cotiers en Atlantique Nord-Est (Golfe de Gascogne, Manche)”.

En assurant la dispersion, la phase larvaire joue un role fondamental dans la dynamique des populations d’invertébrés marins à cycle de vie bentho-pélagique et détermine la connectivité au sein des métapopulations marines. La connectivité en milieu marin influence ainsi directement la dynamique des métapopulations et la persistance des populations locales, les potentialités d’expansion des espèces en réponse à des changements des conditions environnementales ou les limites biogéographiques d’aire de distribution des espèces. Dans ce contexte, le but du présent travail a été de mieux comprendre les roles relatifs joués par les processus hydrodynamiques et hydroclimatiques, et les traits d’histoire de vie des invertébrés sur la dispersion larvaire et la connectivité en milieu cotier dans le Golfe de Gascogne et la Manche occidentale. Pour cela, un modèle lagrangien générique de dispersion larvaire a été développé à l’échelle de la zone d’étude. Les résultats issus de simulations de la dispersion en conditions hydroclimatiques réalistes ont souligné l’importance de la variabilité saisonnière des conditions hydroclimatiques et des traits d’histoire de vie (mois de ponte, durée de vie larvaire, comportement natatoire) dans le transport larvaire et la connectivité entre populations. Ces résultats ont suggéré de possibles échanges larvaires depuis les populations cotières du Golfe de Gascogne vers celles de la Manche occidentale, i.e. à travers une zone de transition biogéographique. Ils ont aussi permis de tester plusieurs hypothèses sur les conséquences possibles du changement climatique sur la dispersion et la connectivité entre populations marines, i.e. via une période de ponte précoce et une durée de vie larvaire raccourcie.

Olivier Bernard : “Hurdles and challenges for modelling and control of microalgae for CO2 mitigation and biofuel production”

Oleaginous microalgae are seen as a potential major biofuel producer in the future since, under conditions of nitrogen deprivation, they can contain high amounts of lipids, while they consume CO$_2$ from power plants. These photosynthetic microorganisms are however rather different from the microorganisms usually used in biotechnology. In particular, predicting the behaviour of microalgal based processes is delicate because of the strong interaction between biology (microalgal development and respiration), and physics (light attenuation and hydrodynamics). This paper reviews existing models, and in particular Droop Model which has been widely used to predict microalgal behaviour under nutrient limitation. It details a model for photobioreactors or raceways, when both light and nutrients are limiting. The challenges and hurdles to improve photobioreactor modelling and control in order to optimise biomass or biofuel production are then discussed.

Andrei Akhmetzhanov : “ESS versus cooperative behaviour in a consumer-resource model”

In this work we consider a system of two interacting populations of consumers and resources. It is assumed that the two populations interact during a season of length T and die at the end of it. Reproductive processes occurring during the season determine the size of the populations at the beginning of the next season.

We assume that the resource population behaves passively and the consumers have some control on their reproduction: they must choose between investing their time in foraging the prey, what increases their reproductive capacities, or in reproducing. The maximization of the consumers fitness (strictly speaking their number of descendants in the next generation) has been studied previously but is shown to be not evolutionarily stable (ESS) as a population using such a strategy might be invaded by some mutants that take advantage of their small density and non-cooperative behavior.

We propose here to investigate a prevention strategy for the consumer population which does not allow any mutant to invade. Such a strategy would be ESS but not optimal with respect to the maximization of the fitness. We show how such a strategy can be obtained as the solution of a zero-sum differential game.

Moreover, we compare these two reproductions strategies in terms of their influence on the dynamics of the system through many seasons. Though not ESS, the optimal strategy leads to a stable situation in a long-term perspective. On the contrary, the prevention strategy is ESS but it is not long-term stable and leads to an instance of the so-called “Tragedy of the Commons”.

Valérie Lemesle : “Evolution de la résistance des bio-agresseurs soumis a des plantes toxiques”

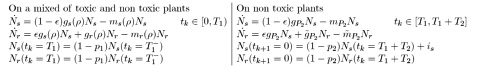

Toxic plants, genetically modified or selected for antibiosis properties, produce toxins that are harmful to agricultural pests and have been used for years in agriculture. However, the continuous exposure of targeted pests to toxins increases the rate of resistance evolution. To prevent or delay resistance, non toxic host plants can be used as refuges. Our study considers spatial and temporal refuges that are implemented successively. A conceptual model based on impulsive differential equations is proposed to describe the dynamics of the susceptible and resistant pest populations over time. With T2 denoting the time length of a cropping season, k the season number, Ns and Nr the susceptible and resistant pests, the model reads :

- OBJECTIFS :

-

where _ is the mutation rate, _ the proportion of toxic plants, gs(_), gr(_) and gP2 , ~gP2 the growth rates, ms(_), mr(_) and mP2 , ~mP2 the death rates. Seasonal harvests are assumed to remove a proportion pi; i = 1; 2 of each sub populations. Moreover we suppose that inter-crop immigration is composed of susceptible pests only denoted is. The mathematical study enlightens threshold values of the proportion of spatial refuge and key parameters that should help to understand evolution of pest resistance to toxic crop. Our modelling approach, based on pure demographic parameters, could be improved by adding quantitative genetics processes to derive a demo-genetic model. The very first results seem to show that immigration favours a bistable behaviour in the model: either resistant pests persist in the system or go extinct. This will be discuss at the end of the talk and enlightens new biological insights with respect to the use of toxic plants as a sustainable pest management strategy.

Pierre Bernhard : “Paradoxe du handicap et théorie des jeux”

Cf article “A dynamic approach of the “Handicap Principle”, Pierre Bernhard, October 10, 2010”

Stéphanie Sorres : “Tout ce que vous devez savoir sur COMORE”

Informations administratives à destination des personnels de l’équipe (rappel délais organisation des déplacements professionnels, dates de fin de gestion INRIA, actualités administratives INRIA…

-

Frédéric Grognard : “Lutte biologique, besoin d’action et de compréhension”

Dans cet exposé, nous avons présenté les différents résultats de l'année obtenus dans le thème “Lutte biologique” au sens large par l’équipe Comore. Ces résultats vont de modèles et lois de commande pour l'application de la lutte biologique inondative à des modèles de compréhension des comportements des insectes au cours de leur vie, ainsi que de la compréhension d'effets de migration.

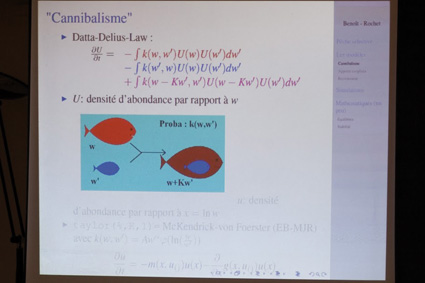

Jonathan Rault : “A continuous size structured model applied to zooplankton community”

Size appears to be a very good indicator of physiological behaviour in the zooplankton community, like predation or even detritus production. In order to get a better understanding of planktonic ecosystem dynamics, we build a continuous size-structured model. This approach is very popular in sh studies (Benoit and Rochet, 2004; Andersen and Pedersen, 2009). Our model incorporates predation on phytoplankton and cannibalism within the zooplankton community, and various predation behaviours are tested.

Mathematical results are in the most cases hard to get in such models.

Nevertheless for some choice of predation function, and external mortality, we can obtain mathematically equilibria. Numerical simulations show that these equilibria are not always stable, and Hopf bifurcations appear when model parameters vary.

Frédéric Grognard : “Optimisation de la production de biomasse dans un photobioréacteur en régime jour/nuit”

Dans cet exposé, nous abordons la question de l’optimisation de la production de biomasse de microalgues en photobioréacteurs sous l’influence de cycles jour/nuit. Pour cela, nous proposons un modèle simple de bioréacteur tenant compte explicitement de l’atténuation lumineuse dans le réacteur, due à l’auto-ombrage de la biomasse. Nous avons obtenu une loi de commande qui optimise la productivité sur une seule journée par l’application du principe du maximum de Pontryagin, le taux de dilution étant la commande.

Une contrainte importante sur la solution obtenue est que la biomasse dans le réacteur doit être au même niveau au début et à la fin de la journée de sorte que le même contrôle puisse être appliqué le lendemain et ainsi optimiser la productivité à long terme.

Pierre Collet : “ACV dynamique de la production de biogaz à partir de microalogues”

La raréfaction des ressources pétrolières et le changement climatique ont amené de nombreux groupes de recherche et d’industries privées à s’intéresser à l’utilisation de la biomasse pour la production de bioénergie. La production et l’utilisation des carburants de 1ère génération induisent d’une manière générale un réchauffement climatique potentiel plus faible que le pétrole mais engendrent d’autres impacts environnementaux par transferts de pollution et entrent en compétition avec des surfaces à vocation alimentaire. Les microalgues représentent une solution alternative intéressante de par leur haut rendement photosynthétique et leur haute teneur en lipides. Cependant, l'analyse environnementale de la production de biocarburant à partir de biomasse de microalgues a mis en lumière le contenu énergétique important des tourteaux d’algues obtenus après extraction de l’huile. Une des solutions proposées pour valoriser de manière plus optimale le contenu énergétique des microalgues est la digestion anaérobie de celles-ci qui conduit à la production de biogaz pouvant être valorisé sous forme de chaleur, d’électricité ou de fuel. Ce couplage culture de microalgues / digestion anaérobie est au cœur du projet ANR Symbiose.

Une Analyse de Cycle de Vie (ACV) a été réalisée de manière à évaluer les impactes environnementaux de cette filière de production d'énergie et d'identifier les principaux verrous technologiques. L’ACV peut être définie comme étant “un outil d’évaluation des impacts sur l’environnement d’un système incluant l’ensemble des activités liés à un produit ou à un service depuis l’extraction des matières premières jusqu’au dépôt et traitement des déchets”. Aujourd’hui l’ACV est un outil qui ne prend en compte que des états stationnaires, c’est-à-dire que les dynamiques des différents procédés constituant le système ne sont pas prisses en compte.

Le travail de cette thèse est d’évaluer la pertinence et la faisabilité d’introduire une dynamique temporelle en ACV, et d'appliquer ces résultats au système Symbiose en se basant sur le couplage d'un modèle de croissance d’algues avec un modèle de digestion anaérobie.

- Ludovic Mailleret : “Evolutionary branching of plant pathogens in temperate ecosystems”

We are interested in the evolutionary epidemiology of crop plant parasites. Their peculiarity is to face abrupt changes in host density due to planting and harvesting, as periodic events. The associated models thus combine continous (epidemiological) and discrete (host population) dynamics. This is termed “semi-discrete” modelling in the Mathematical Biology literature. Performing an “evolutionary invasion analysis” (sensu Adaptative Dynamics theory), we show that evolutionary branching of the parasite phenotype can occur, assuming there is a trade-off between intra- and inter-season transmission abilities. Since there are experimental evidences for such a trade-off (e.g. in the take-all parasite of wheat), our model provides the ecological and phenotypical bases for the coexistence of genetically distinct subgroups in the parasite population (as observed in e.g. the take-all of wheat also). We discuss why this evolutionary insight was not captured in previous and recent research. (This is a joint work with Frédéric Hamelin, Magda Castel and Sylvain Poggi.)

Jean-Luc Gouzé : “A theoretical exploration of birhythmicity in the p53-Mdm2 network”

Experimental observations performed in the p53-Mdm2 network, one of the key protein module involved in the control of proliferation of abnormal cells in mammals, revealed the existence of two frequencies of oscillations of p53 and Mdm2 in irradiated cells depending on the irradiation dose. These observations raised the question of the existence of birhythmicity, i.e. the coexistence of two oscillatory regimes for the same external conditions, in the p53-Mdm2 network which would be at the origin of these two distinct frequencies. A theoretical answer has been recently brought by Ouattara, Abou-Jaoudé and Kaufman who proposed a 3-dimensional differential model showing birhythmicity to reproduce the two frequencies experimentally observed.

The aim of this work is to analyze the mechanisms at the origin of the birhythmic behavior through a theoretical analysis of this differential model. To do so, we reduced this model, in a first step, into a 3-dimensional piecewise linear differential model where the Hill functions have been approximated by step functions, and, in a second step, into a 2-dimensional piecewise linear differential model by setting one autonomous variable as a constant in each domain of the phase space. We find that two features related to the phase space structure of the system are at the origin of the birhythmic behavior: the existence of two embedded cycles in the transition graph of the reduced models; the presence of a bypass in the orbit of the large amplitude oscillatory regime of low frequency.

Based on this analysis, an experimental strategy is proposed to test the existence of birhythmicity in the p53-Mdm2 network. From a methodological point of view, this approach greatly facilitates the computational analysis of complex oscillatory behavior and could represent a valuable tool to explore mathematical models of biological rhythms showing high enough nonlinearities.

Eric Benoit : “Influence de la pêche (sélectivité, cible pêchée) sur la dynamique des spectres de taille des populations de poissons. Modélisation, simulations, commentaires”

L'IFREMER a comme but d'optimiser le fonctionnement des pêcheries dans le sens suivant :

1) Préserver la ressource (point de vue biologique)

2) Maximiser la capture (au sens économique du terme)

3) Régulariser la capture (pour éviter les grandes variations sur le marché)

Pour cela, on a besoin d'une modélisation de la dynamique de population des poissons. On a choisi une modélisation structurée en poids, où le moteur principal est la prédation d'un poisson de poids w sur un poisson de poids w0. On donne différents modèles exploitant cette idée.

Dans les modèles, on insère la mortalité par pêche, dépendant de deux paramètres : l'intensité de l'effort de pêche et la plus ou moins grande sélectivité (en taille) des captures. Ces deux paramètres correspondent aux règles édictées par les autorités pour réguler les pêcheries.

On montre des simulations de ces modèles, pour étudier qualitativement l'influence des paramètres sur les différents objectifs.

On évoque les problèmes mathématiques correspondants.

Olivier Calabro : “Le logiciel ODIN, version micro-PC”

• Le besoin : Plateforme de supervision de bioréacteurs, usage d'algorithmes avancés

• Structure de l’application : Acquisition des mesures sur le bioréacteur, calcul des commandes à appliquer, diagnostique, archivage, interface utilisateur

• Historique: un parcours non-linéaire...

• Etape Courante (2009-2011) : Preparer la valorisation de la plateforme, utilisation interne, miniaturisation

• Architecture et détail de fonctionnement (bioProcess’s, superviseur, interface utilisateur)

• Partenaire de l’Inria: LBE, LOV...

• Réalisations : Fiabilisation, optimisation, portage sous Windows

• Applications actuelles et actions futures

• Questions / démonstration

Mickaël Teixeira : “Optimal Foraging dans les modèles proie-prédateur de type Leslie-Gower, avec source de nourriture alternative”

Dans un cadre d’une protection plus saine et écologique des cultures, la lutte biologique est une alternative d’avenir aux pesticides. Une des méthodes de lutte biologique consiste en l’insertion d’un prédateur naturel antagoniste des ravageurs des cultures. L’intérêt de l'utilisation d’un prédateur dépend des décisions qu’il prend pour se nourrir. Entre autres, il peut consommer toutes les espèces de son environnement ou chercher à maximiser sa croissance en n'en consommant qu’une. Le modèle modifié de Leslie-Gower nous permet de représenter un système composé d’un prédateur généraliste, d’une proie principale et d'une nourriture alternative constante ou dynamique. L’analyse des modèles de type Leslie-Gower a montré que la présence d'une source de nourriture alternative a des effets négatifs sur la dynamique de la proie principale lorsque le prédateur généraliste consomme toutes les proies à la fois. A l’opposé, lorsque le prédateur généraliste choisit de ne manger qu’une proie, alors la présence d’une nourriture alternative a un effet neutre ou bénéfique sur la proie principale. En conclusion, l’utilisation de prédateurs généralistes en lutte biologique est peu évidente. De plus, la dynamique des populations est particulièrement sensible aux paramètres démographiques qui sont à prendre en compte lors du choix d’un prédateur généraliste.

Xiao-Dong Li : “Observation et commande de quelques systèmes à paramètres distribues”

On s’intéresse au problème de stabilisation d’un système vibrant décrit par des EDP. L’implémentation de la loi de commande stabilisante nécessite toutes les informations sur la dynamique du système qui est partiellement non mesurable. Un observateur du type Luenberger de dimension infinie exponentiellement convergent est proposé dans l’optique d’estimer toutes les variables d’état du système. L’observateur est valable pour une vitesse angulaire en temps variant autour d'une constante. La vitesse de convergence de l’observateur peut être accélérée en tenant compte d’une seconde étape de conception. En utilisant la méthode des éléments finis, plusieurs simulations sont effectué, y compris une étude numérique pour le système avec la vitesse angulaire variante en fonction du temps. L’influence du choix de gain est examinée sur la vitesse de convergence de l’observateur. La robustesse de l’observateur est testée face à la mesure corrompue par du bruit. En mettant en cascade notre observateur et une loi de commande stabilisante par retour d’état, on souhaite obtenir une stabilisation globale du système. Des résultats numériques pertinents permettent de conjecturer la stabilité asymptotique du système en boucle fermée.

Nina Moelants : “Optimizing the sustainable performance of compact decentralized wastewater treatment systems”

Decentralized wastewater treatment systems can provide a useful solution in remote regions where connecting houses to a sewer network is financially not feasible. The performance (i.e., C, N, and P removal) of many of these systems is, however, sub-optimal. Complex models for large-scale wastewater treatment systems already exist and are frequently used for design and optimization purposes. On the other hand, simple, practically useful models for decentralized systems have not yet been reported in literature. Therefore, an integrated carbon removal model is proposed in this presentation. This model, based on the state-of-the-art ASM1 models, but with a complexity in balance with the available measurements, can be used by manufacturers of decentralized systems to optimize the operational design of their systems and check the impact of different events on the carbon removal efficiency of the system. The model was built for one specific type of system, but the procedure used to construct the model is generic and can be applied to different types of decentralized systems.